Article. What i write

Intelligenza Artificiale Generativa (GenAI) e Cybersecurity

Pubblicato il 10 febbraio 2025

L'intelligenza artificiale generativa (GenAI) viene utilizzata sia dai privati che dalle aziende pubbliche e private. Di seguito, illustriamo alcuni dei principali rischi per la sicurezza dell'IA generativa, che sono reali ma non possono essere ignorati, e a cosa occorre prestare attenzione. Inoltre, analizziamo come l'IA generativa potrebbe influire sul mondo della cybersecurity.

Dalla comparsa di ChatGPT, l'intelligenza artificiale generativa, spesso paragonata alla rivoluzione industriale moderna, ha suscitato grande interesse in tutto il mondo. Tuttavia, l'adozione di nuove tecnologie comporta nuovi rischi per la sicurezza e l'IA generativa non fa eccezione. Pertanto, è fondamentale adottare un approccio consapevole ai rischi associati all'uso di questa tecnologia. Inoltre, poiché l'IA generativa è altamente versatile, non si possono ignorare non solo i rischi per la sicurezza dell'IA stessa, ma anche la possibilità che possa influenzare l'intero settore della sicurezza informatica.

Il termine "AI generativa" viene talvolta utilizzato in varie accezioni, ma questo articolo si limita all'IA interattiva che utilizza un large language model (LLM), come ChatGPT.

Si individuano tre ambiti di rischio legati alla GenAI:

1. I rischi per gli utenti che usano la GenAI

2. I rischi dell'integrazione della GenAI nei servizi IT/OT

3. L’impatto della GenAI sulla sicurezza informatica

Rischi per gli utenti che usano la GenAI

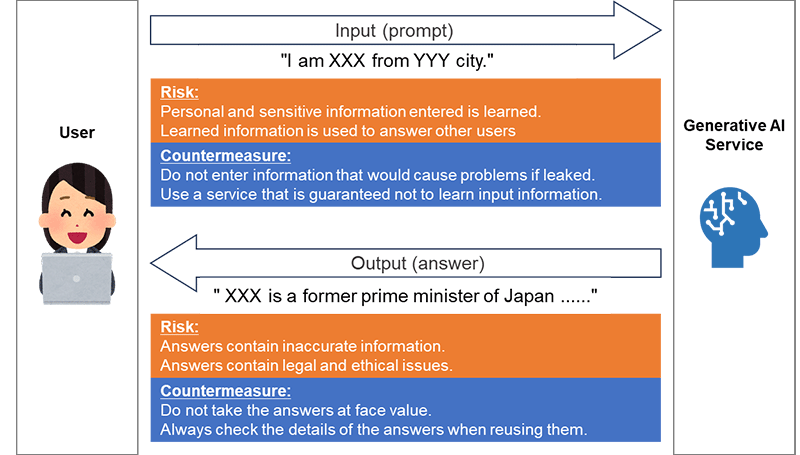

In primo luogo, è importante che gli utenti di servizi come ChatGPT conoscano i rischi per la sicurezza connessi alla GenAI. Durante l'interazione tra l'utente e l'IA generativa, l'utente immette un'istruzione chiamata "prompt" e l'IA generativa produce la risposta in base alle informazioni ricevute.

I due rischi principali ipotizzati sono la fuga di informazioni in ingresso e la produzione di informazioni inappropriate.

In primo luogo, la fuga di informazioni potrebbe verificarsi se le informazioni immesse da un utente nell'IA generativa venissero utilizzate come materiale di apprendimento per lo stesso sistema. Le informazioni immesse potrebbero essere incluse nell'output di altri utenti, causando una fuga di informazioni. Le contromisure da adottare consistono nel vietare l’immissione di informazioni che non dovrebbero essere divulgate o nell'utilizzare un servizio che non utilizzi le informazioni in ingresso per l'apprendimento e che garantisca un'adeguata gestione delle informazioni stesse.

Il secondo rischio è la produzione di informazioni inappropriate. L'IA generativa può plausibilmente produrre contenuti non veritieri e questo fenomeno è noto come "allucinazione". Può anche causare problemi legali ed etici, come la violazione del diritto d'autore, la discriminazione e i pregiudizi. Per ridurre questi output inappropriati, gli sviluppatori di IA generativa stanno lavorando per affrontarli. Tuttavia, al momento è difficile eliminarli completamente e gli utenti devono essere consapevoli dei rischi presenti negli output dell'IA generativa e fare attenzione a non considerarli attendibili. In particolare, quando l'output viene riutilizzato, ad esempio per creare un report basato sull'output dell'IA generativa, gli utenti devono essere responsabili della sua verifica in termini di accuratezza e conformità.

Figura 1 - Rischi per la sicurezza dal punto di vista degli utenti dei servizi di IA generativa

I rischi dell'integrazione della GenAI nei servizi IT/OT

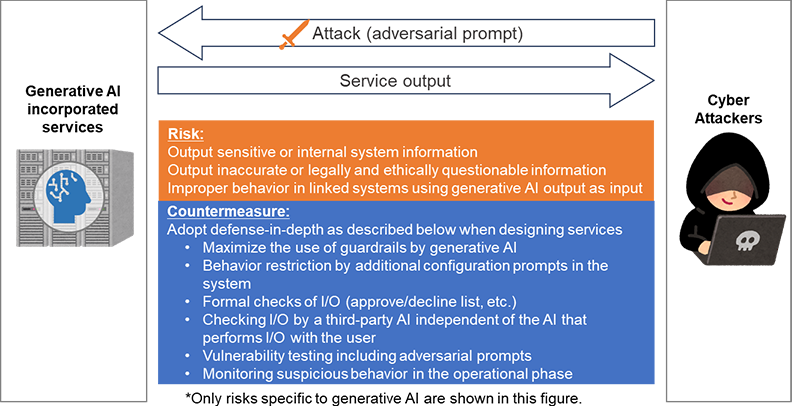

Analizziamo i rischi per la sicurezza dal punto di vista di un fornitore che offre un servizio che incorpora l'IA generativa. L'interfaccia di chat viene utilizzata come punto di contatto temporaneo con gli utenti e questo sarebbe un tipico caso d'uso in cui si fa uso dell'IA generativa. In questo caso, il rischio è quello di ottenere un output scorretto a causa di un input inaspettato da parte dell'utente. Esaminiamo nel dettaglio l'input e l'output.

L'input può essere preso di mira non solo dagli utenti comuni, ma anche dagli hacker malintenzionati. I cyberattaccanti inseriscono prompt creati ad arte per generare intenzionalmente output inappropriati che non si verificherebbero normalmente. Questi messaggi sono detti "prompt avversari". I servizi che utilizzano l'IA generativa per apprendere gli input degli utenti devono anche considerare il rischio di un output distorto a causa di una grande quantità di input politicamente o eticamente distorti.

Poi c'è l'output che, se inserito un input contenente un prompt avversario, rischia di causare tre problemi.

- Perdita di informazioni attraverso l'emissione di informazioni su altri utenti o informazioni interne al sistema.

- Risposte inappropriate come servizio, come errori di fatto, pregiudizi, discriminazione, incitamento al crimine o violazione del copyright.

- Attivazione di un comportamento indesiderato di un sistema collegato quando l'output di un'IA generativa viene utilizzato come input per il sistema collegato.

Come contromisura comune, oltre al meccanismo di soppressione delle risposte inappropriate fornito dagli sviluppatori di IA generativa menzionato nella sezione precedente, è necessario considerare le contromisure a più livelli elencate di seguito.

- Limitare il comportamento con richieste aggiuntive nel servizio (ad esempio, non rispondere a domande che esulano da una specifica area).

- Controlli formali di I/O (ad esempio, consentendo solo l'uscita "Sì" o "No")

- Verifica dell'I/O con un'IA generativa indipendente, diversa dall'IA generativa che esegue l'I/O con l'utente.

- Test di vulnerabilità, compresa l'implementazione di prompt avversariali.

- Monitoraggio dei comportamenti sospetti dell'IA generativa e dei sistemi collegati durante la fase operativa

Poiché il grado di libertà dell'input/output diminuisce con l'inasprimento delle contromisure, è necessario stabilire quali limiti imporre in base alla natura del servizio offerto. Per i servizi con bassa tolleranza di rischio, è necessario valutare se sia realmente possibile impiegare l'IA generativa.

L'Open Web Application Security Project (OWASP), un'organizzazione internazionale che si occupa di sicurezza delle applicazioni, ha pubblicato la "OWASP Top 10 for LLM Applications", che descrive i rischi particolarmente gravi per la sicurezza delle applicazioni LLM-enabled.

Figura 2 - Rischi per la sicurezza dal punto di vista dei fornitori di servizi generativi basati sull'IA

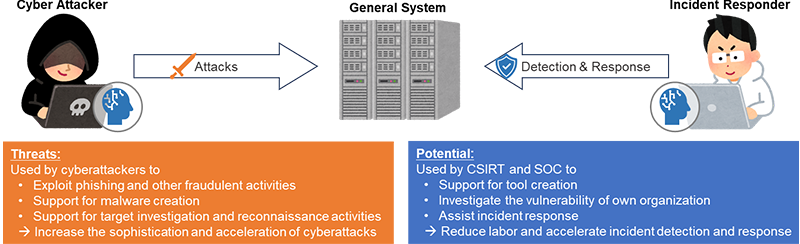

L’impatto della GenAI sulla sicurezza informatica

Abbiamo discusso i rischi per la sicurezza e le contromisure dell'IA generativa in sé. In questa sezione ci allontaneremo da questo argomento per considerare l'impatto dell'IA generativa sulla sicurezza informatica nel suo complesso. A differenza del software convenzionale, l'IA generativa è facile da usare ed estremamente versatile. Pertanto, lo sviluppo dell'IA generativa influenzerà la cybersecurity in vari modi.

Si ipotizza che venga utilizzata per migliorare la sofisticazione e l'efficienza dei cyberattacchi già esistenti, come descritto di seguito.

- Sfruttamento a fini fraudolenti: generazione di e-mail e fake news per scopi di phishing e business email compromise (BEC) (non solo l'IA interattiva oggetto di questo articolo, ma anche i generatori di IA di immagini, audio e video sono efficacemente utilizzati).

- Supporto alla creazione di malware: i malware avanzati sono difficili da creare con l'attuale IA generativa, ma gli aggressori esperti la sfruttano come strumento di supporto alla programmazione per aumentare l'efficienza della creazione.

- Supporto alle indagini e alle ricognizioni: automazione ed efficienza del processo decisionale umano nelle indagini e nelle ricognizioni pre-attacco.

Questi usi malevoli avrebbero dovuto essere impediti dai limiti di sicurezza incorporati nell'IA generativa, ma gli aggressori hanno perfezionato le richieste avversarie per aggirare tali limiti. Gli sviluppatori dell'IA generativa hanno inasprito i limiti e ora esistono IA generative sintonizzate per i cyberattacchi senza limiti di output, vendute ai cyberattaccanti come attività in nero.

Tuttavia, i cybercriminali non sono gli unici a beneficiare dell'IA generativa. Anche i team di risposta agli incidenti informatici (CSIRT) e i centri operativi di sicurezza (SOC) devono utilizzare attivamente l'IA generativa per combattere gli attacchi informatici. In futuro, potremmo vedere sistemi di difesa completamente automatizzati fermare attacchi completamente automatizzati. Tuttavia, al momento, è difficile affidarsi completamente all'IA generativa per gestire tutto questo, quindi è probabile che, per il momento, l'IA generativa venga utilizzata per aumentare la produttività e sopperire alla mancanza di risorse umane per:

- Supporto alla creazione di strumenti: - supporto alla creazione di strumenti per semplificare le operazioni quotidiane dei CSIRT e dei SOC, nonché le operazioni di investigazione e risposta agli incidenti.

- Indagine sulle vulnerabilità: Il rovescio della medaglia dell'indagine e della ricognizione degli aggressori consiste nel semplificare l'individuazione dei luoghi (le cosiddette "superfici di attacco") che potrebbero essere oggetto di attacco da parte dell'organizzazione.

- Assistente: fornisce assistenza nelle operazioni di investigazione e risposta agli incidenti informatici. Gli utenti devono possedere un certo livello di competenze per poter fornire istruzioni accurate.